Maschinelles Lernen im Dreiklang

Auch im dunkelsten Dämmerzustand sind wir noch in der Lage, unserem Smart-phone ein »Stell‘ den Wecker auf 6.30 Uhr« zuzuwerfen. Die Antwort der beruhigend elektronischen Stimme gibt uns die Gewissheit, friedlich einschlafen zu können. Hinter diesem alltäglichen Austausch verbergen sich komplexe Methoden der Datenauswertung. Ein Zusammenspiel aus Textgenerierung (Natural Language Generation, NLG), Computerlinguistik (Natural Language Processing, NLP) und Maschinellem Lernen (ML) zaubert eine intelligente Assistentin für alle Fälle.

Heutzutage profitieren wir in den meisten Lebensbereichen von Datenauswertungsmethoden, nicht nur im Privaten, sondern auch in der Industrie. Soll beispielsweise ein neues Produkt auf den Markt kommen, so entstehen von Beginn seines Lebenszyklus an eine Menge von Daten mit wichtigen, meist impliziten Erkenntnissen zum Produkt selbst und den damit verbundenen Herstellungsprozessen. Die Auswertung durch Mitarbeitende in der Produktentwicklung wäre eine Mammutaufgabe. An dieser Stelle bieten Methoden des Maschinellen Lernens Unterstützung. Diese Methoden werten vorhandene Daten maschinell aus. Mitarbeitende können die daraus hervorgehenden Erkenntnisse nutzen, um Fertigungsprozesse zu optimieren, Problemfälle schneller zu lösen sowie die Produktqualität insgesamt zu verbessern. Die Möglichkeiten sind schier endlos.

Ein wirksames Trio

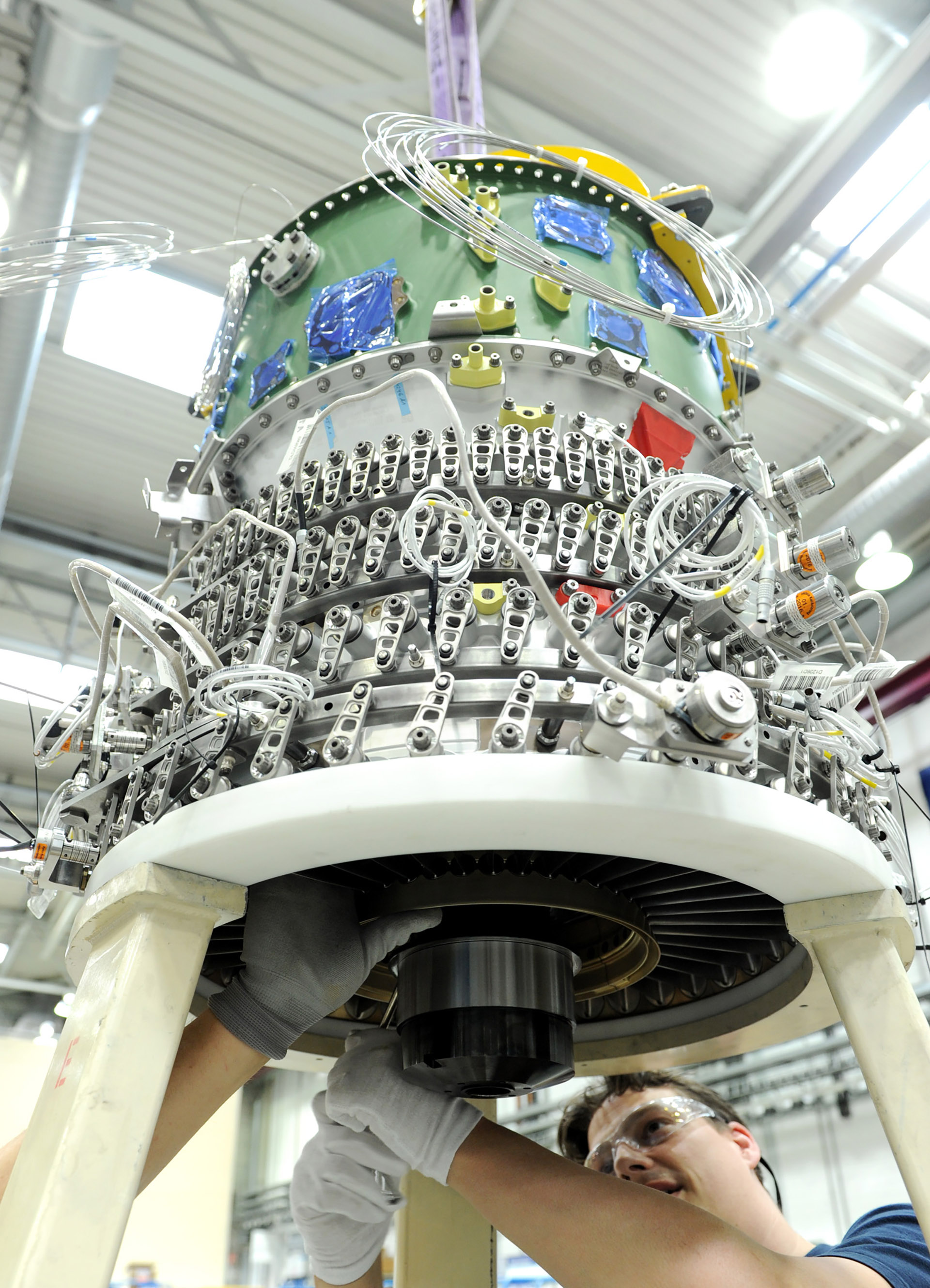

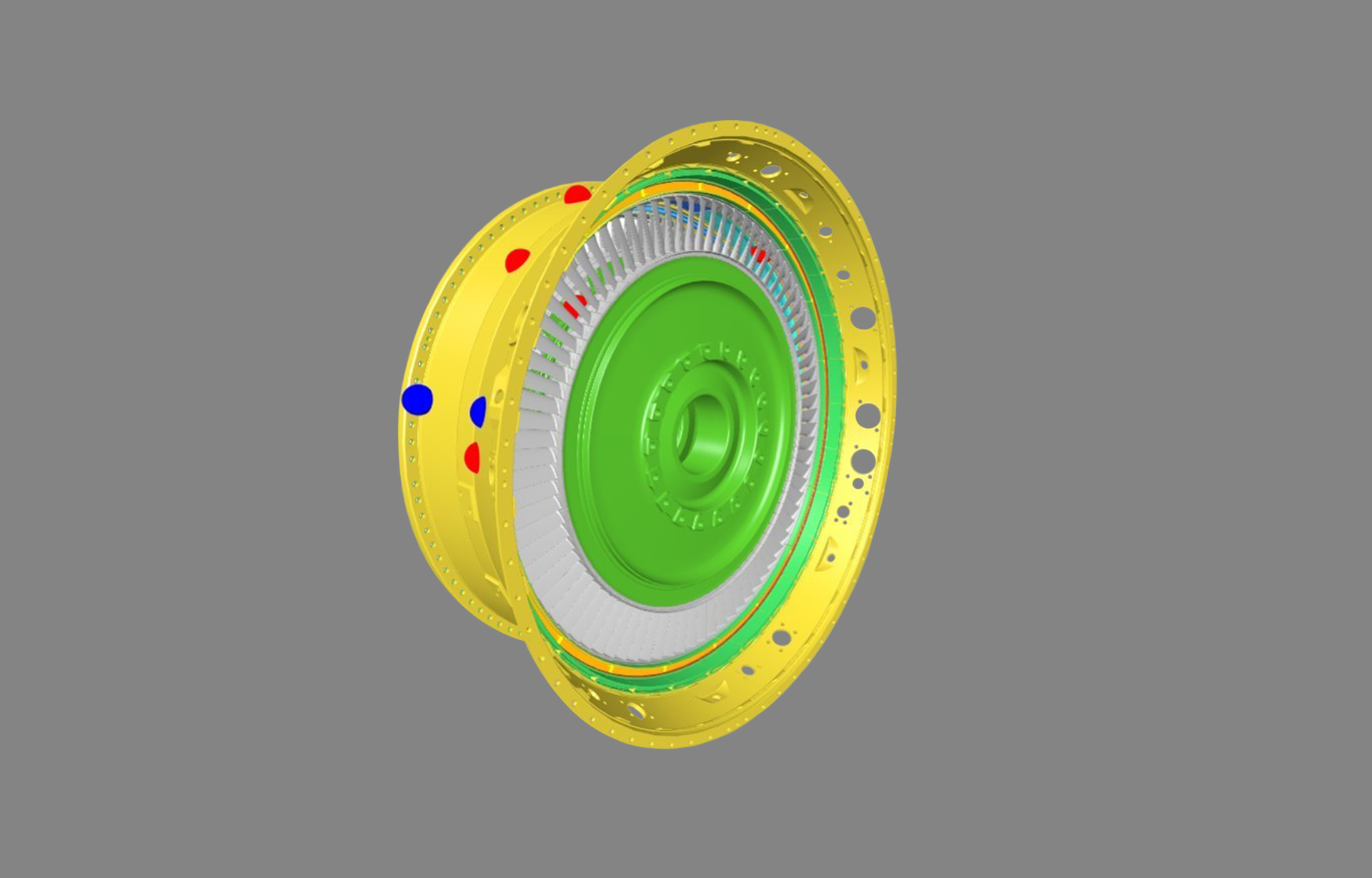

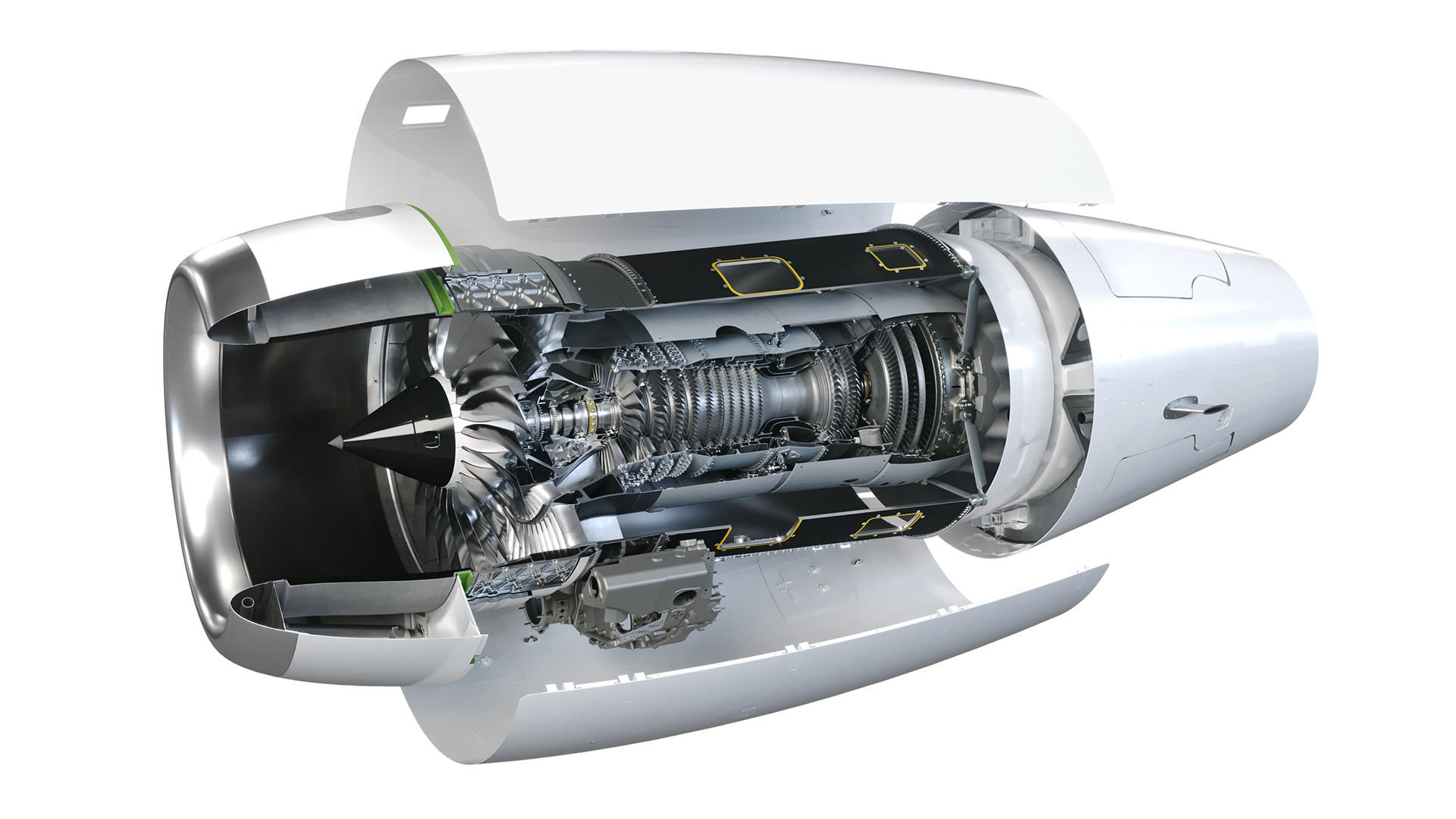

In einem Kooperationsprojekt mit Rolls Royce Deutschland, genannt Cockpit 4.0, entwickelten Forschende des Fraunhofer IPK ein virtuelles Assistenzsystem, das ML-Methoden einsetzt, um nützliche Erkenntnisse für die Lösung von Fertigungs- und Montageproblemen abzuleiten. Fehlt beispielsweise ein Turbinenteil während des Montageprozesses, kann ein Team mit der Auffindung beauftragt werden. So können Verzögerungen im Montageprozess vermieden werden. Dafür wurden drei ML-Ansätze an den verfügbaren Daten getestet:

1. Natural Language Processing (NLP)

Das Natural Language Processing (NLP) ist eine maschinelle Lernmethode zur Verarbeitung natürlicher Sprache. Im Projekt wurde NLP verwendet, um Übereinstimmungen mit vorhergehenden Beschreibungen von Problemen zu identifizieren, sodass Rückschlüsse auf aktuelle Fälle möglich sind. Man unterscheidet automatisch und selbst trainierte Modelle; letztere werden durch die Forschenden eigenständig mit speziellem Vokabular trainiert.

Dabei wurden drei verschiedene NLP-Algorithmen verwendet: ein Bag-of-Words-Modell, ein selbst trainiertes Word2Vec-Modell und ein automatisch trainiertes Word2Vec-Modell. Bei dem Bag-of-Words-Modell werden die einzelnen Begriffe vorhergehender Problembeschreibungen ohne Beachtung der Grammatik ausgewertet und mit Begriffen aktueller Fälle verglichen. Zur Ähnlichkeitsmessung wurde der Jaccard-Koeffizient eingesetzt. Der zweite NLP-Algorithmus wurde von den Forschenden selbst trainiert. Er basiert auf einem Word2Vec-Modell, das Begriffe vektorisiert, sie also nach vorhergehendem Vorkommen klassifiziert. Das zweite Word2Vec-Modell wurde mithilfe von Google News automatisch trainiert. Für beide Word2Vec-Modelle wurde zur Ähnlichkeitsmessung Word Mover’s Distance verwendet. In der Auswertung schnitt das selbst trainierte Modell am besten ab, das von Google News trainierte Modell war am ungenauesten. Diese Tatsache ist darauf zurückzuführen, dass das eigenständige Trainieren, also die Eingabe von branchenspezifischen Begriffen und Abkürzungen im Modell, zu präziseren Ergebnissen führt. Die Ergebnisse zeigen deutlich, dass das eigenständige Trainieren der Modelle für eine präzise Wortfindung unabdingbar ist.

2. Regressionsbasierter Ansatz

Der Regressionsbasierte Ansatz wird häufig verwendet, um Ergebnisse auf der Grundlage von Variablen vorherzusagen. Im Fall von Cockpit 4.0 dient er vor allem zur Generierung eines Modells, das die benötigte Bearbeitungsdauer eines eingehenden Falls bzw. Problems vorhersagen kann. Diese Information kann hilfreich sein, um dessen Priorität zu bestimmen. So können bei zeitintensiven Fällen entsprechende Maßnahmen ergriffen werden, um die Zeitspanne zu verkürzen, bis das Problem behoben ist. Das Start- und Enddatum der Fälle wird generiert, um die Dauer jedes Falles mithilfe von überwachtem Lernen, also der Datenverarbeitung durch vordefinierte Parameter, zu ermitteln. Es wurden vier Arten von Regressionsmodellen trainiert, nämlich die lineare Regression, die Lasso-Regression, ein Stütz-vektor-Regressionsmodell (SVM) sowie ein Modellbaum mit SVM. Der Modellbaum mit Stützvektor-Regressionsmodellen erzielte die niedrigste Fehlerquote.

3. Clustering

Das sogenannte Clustering ist eine weitere Methode des maschinellen Lernens, mithilfe derer verschiedene Datenpunkte bestimmten Gruppen zugeteilt werden können. Im Projekt wurde der Clustering-Ansatz zur Aufteilung der Datensätze in Cluster eingesetzt, um Ähnlichkeitsmuster zu identifizieren. Die Cluster können der nutzenden Person mithilfe des unüberwachten Lernens ähnliche Fälle liefern, die als Ausgangspunkt für ihre Recherche zur Lösung des aktuellen Problems dienen.

Es wurden drei Arten von Clustering-Algorithmen verwendet, nämlich DBSCAN, HDBSCAN und k-Means. Das k-Means-Clustering schnitt qualitativ am besten ab.

Technologie sucht Anwender

Den Forschenden ist es gelungen zu zeigen, dass Unternehmen mithilfe der am Fraunhofer IPK entwickelten Lösung maschinelle Datensätze nutzen können, um Entwicklungs- und Produktionsprozesse durch Ansätze des maschinellen Lernens nachhaltig zu verbessern. Am Ende des Projekts Cockpit 4.0 entstand ein Prototyp, der verschiedene Ansätze im Dreiklang nutzt und von den Endnutzerinnen und -nutzern bei Rolls Royce ausgiebig getestet und evaluiert wurde. Sie bewerteten vor allem die Zeitersparnis bei der Lösung von Montageproblemen als Hauptvorteil. Gleichzeitig wurde klar, dass das virtuelle Assistenzsystem noch weiterentwickelt und verfeinert werden muss, um es lückenlos in den täglichen Arbeitsprozess zu integrieren. Solche Verbesserungen könnten Gegenstand künftiger Forschungsprojekte sein, von denen auch andere Partnerunternehmen aus der Industrie profitieren könnten.

Fraunhofer-Institut für Produktionsanlagen und Konstruktionstechnik

Fraunhofer-Institut für Produktionsanlagen und Konstruktionstechnik