Von Rohdaten zur raffinierten Ressource

So wie kohlebefeuerte Dampfmaschinen die ersten Fabriken zum Laufen brachten und Städte und ganze Nationen durch Eisenbahnen miteinander verbanden, befeuern heute Daten das Internet of Things (IoT) und die Datenhighways innerhalb und zwischen Unternehmen. Und so wie die Entwicklungen des 19. Jahrhunderts weitreichende Infrastrukturmaßnahmen und soziale und politische Reformen mit sich brachten, sehen sich auch im 21. Jahrhundert Unternehmen und Gesetzgeber mit der Notwendigkeit neuer Investitionen und Regularien konfrontiert, um den rasanten technologischen Entwicklungen Rechnung zu tragen.

In produzierenden Unternehmen nimmt aufgrund der Digitalisierung das unternehmensübergreifende Arbeiten mit Daten über den gesamten Produktlebenszyklus zu. Steigende Anforderungen aus der Regulatorik, wie zum Beispiel Lieferkettengesetze oder Transparenzgebote zur Einhaltung von Umweltstandards, treiben den Datenaustausch weiter voran. Um die enormen Datenmengen aus verschiedenen Quellen effizient nutzen und auswerten zu können, benötigen Unternehmen und andere gesellschaftliche Stakeholder die richtigen Technologien und Strategien. In diesem Artikel werfen wir deshalb einen Blick auf die wichtigsten Konzepte und Entwicklungen, die für eine digitale Wertschöpfung nötig sind.

Datenräume: Effizientes Datenmanagement ermöglichen

Datenräume – auch Data Spaces genannt – sind virtuelle Umgebungen oder Plattformen, in denen Daten gespeichert, verwaltet oder ausgetauscht werden können. Sie dienen als sichere und vermehrt auch dezentrale Speicherplätze für verschiedene Arten von produkt-, prozess und unternehmensbezogenen Daten. Darunter fallen beispielsweise Materialdaten von Produkten, Qualitätsdaten aus Fertigungsprozessen oder aber Finanzdaten zum Nachweis der Geschäftsfähigkeit eines Unternehmens.

Datenräume unterliegen dem Souveränitätsprinzip, mit dem sichergestellt wird, dass Unternehmen die Kontrolle über ihre Daten behalten und entscheiden können, wer diese jeweils wann, wofür und unter welchen Bedingungen nutzen darf. Innerhalb von gemeinsamen oder vernetzten Datenräumen können Unternehmen Daten sicher teilen und verwalten. Beispielsweise können sie mit internen Teams standortübergreifend FuE-Aktivitäten durchführen, mit externen Partnern Daten innerhalb der Entwicklungs- oder Lieferkette teilen oder Kunden Nutzungsdaten von Produkten, Maschinen und Anlagen zur Verfügung stellen. So können produzierende Unternehmen Zeit sparen, ihre Kollaborationen effizienter machen und tatsächlich durchgängige Datenketten vom »Schürfen« des Rohmaterials bis zur Verwertung des Produkts und darüber hinaus befähigen.

Datennormierung und -standardisierung: Datenqualität gewährleisten

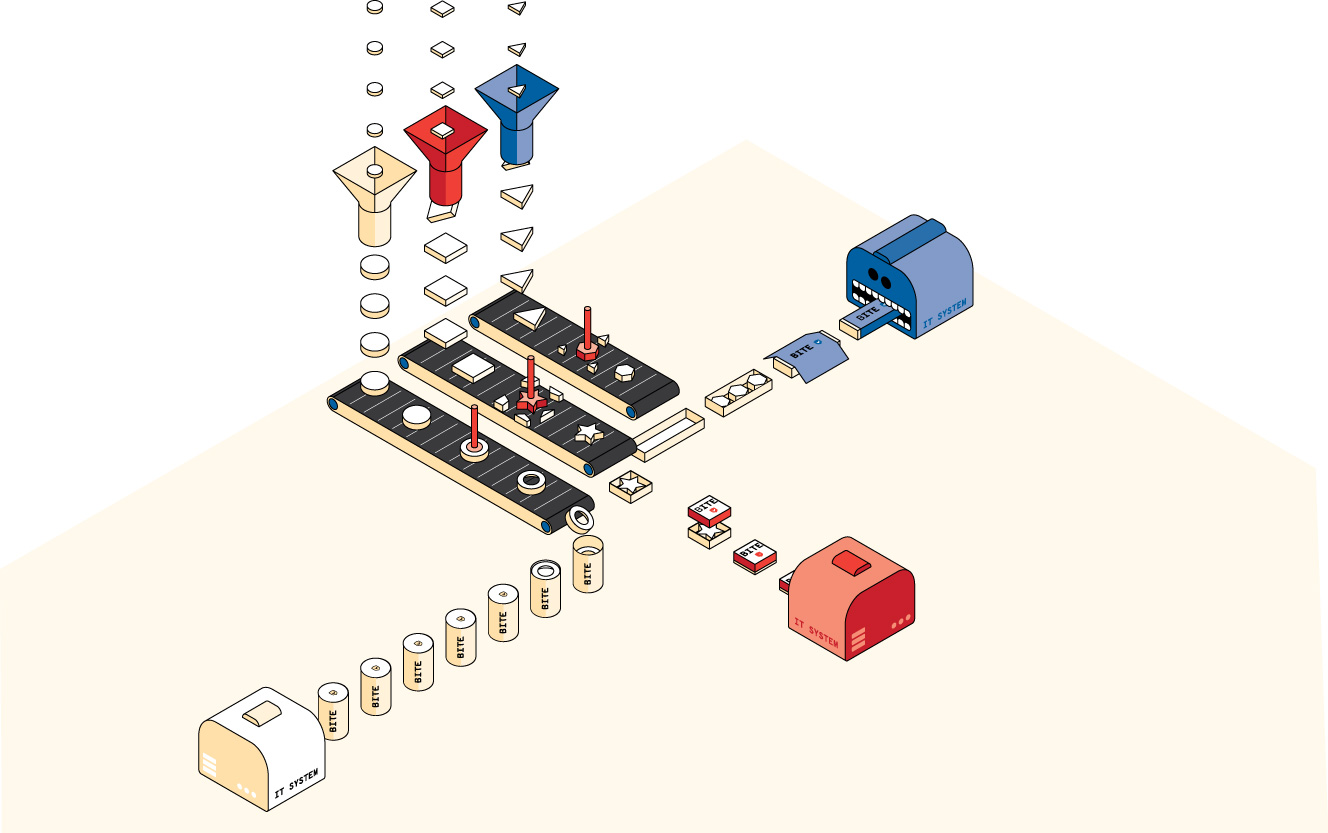

Bei der Datennormierung geht es darum, Daten in einem einheitlichen Format zu strukturieren und zu organisieren, sodass sie in den zuvor genannten Datenräumen leicht ausgetauscht und verarbeitet werden können. Die Standardisierung von Datenmodellen bezieht sich auf die Vereinheitlichung der Strukturen, damit produzierende Unternehmen Daten über verschiedene Datenräume hinweg in unterschiedlichen Prozessen verwenden können. Der Anstoß für Aktivitäten zur Standardisierung kommt derzeit häufig von der Europäischen Union, wie zum Beispiel im Fall des Batteriepasses, in dem ab dem Jahr 2026 die technischen Standards für alle neu angeschafften Batterien in Fahrzeugen, stationären Speichern und größeren Industriebatterien festgehalten werden sollen. Diese werden dann auf nationaler Ebene mit der Verwaltungsschale und standardisierten Submodellen für deutsche Unternehmen konkretisiert. Hierfür sind unter anderem das Deutsche Institut für Normung (DIN) oder Organisationen wie die Plattform Industrie 4.0 und die Industrial Digital Twin Association (IDTA) zuständig.

Ziel von Normierung und Standardisierung ist es, die Vernetzungs- und Datenqualität so zu gewährleisten, dass die Daten konsistent über Datenräume und die darin genutzten Applikationen hinweg verarbeitet werden können. Außerdem ermöglichen sie es, unternehmensübergreifende Berechnungen vorzunehmen, zum Beispiel zum CO2-Fußabdruck eines Produkts, und regulatorische Anforderungen einzuhalten. Daten, die in einem einheitlichen Format vorliegen, sind aber auch besser für maschinelles Lernen und Data Analytics geeignet, da IT-Systeme diese Daten verarbeiten können. Dies erleichtert Unternehmen beispielsweise die Auswertung vernetzter Daten, zum Beispiel für Wartungsarbeiten an Maschinen und Anlagen oder die Bewertung des Produktfußabdrucks entlang des gesamten Lebenszyklus auf Basis von Informationen aus der Lieferkette, Produktion und ggf. auch Nutzung und Wiederverwendung in mehreren Kreisläufen.

Datensouveränität: Kontrolle über die eigenen Daten ausüben

Zentrale Eigenschaft eines Rohstoffs ist, dass dieser weiterverarbeitet wird. Das gilt für Rohöl genau wie für Rohdaten. Damit Unternehmen bei der Verwertung letzterer ihre Handhabe darüber behalten können, gibt es das Prinzip der Datensouveränität. Wörtlich verstanden meint Datensouveränität den selbstbestimmten Umgang mit den eigenen Daten und umfasst die Kontrolle der Erhebung, Speicherung, Nutzung und Verarbeitung eigener Daten. Oftmals ist damit auch die digitale Souveränität gemeint, also die informationelle Selbstbestimmung im digitalen Zeitalter. Neben der Politik und Gesetzgebung reagieren IT-Anbieter auf allen Ebenen auf dieses Prinzip. Sie integrieren digitale Konzepte und Technologien, die sicherstellen, dass Unternehmen ihre digitale Souveränität umsetzen können. Zu diesen gehören u. a. die Initiativen Gaia-X und Catena-X.

Gaia-X ist ein europäisches Vorhaben zum Aufbau sicherer und vernetzter Dateninfrastrukturen, welche die geltenden Gesetze einerseits und die Ansprüche an Souveränität andererseits ins Zentrum rücken. Basis ist dabei die offene Föderation der Protagonisten. Um diese in ihrer Autonomie einerseits und ihrem Kollaborationswunsch andererseits zu unterstützen, werden grundlegende Funktionalitäten bereitgestellt, welche das Auffinden verfügbarer Services ermöglichen, Daten verfügbar machen, Datenmodelle standardisieren und grundlegende Services, beispielsweise zur Authentifizierung bereitstellen. Dieser grundsätzliche Ansatz findet in zahlreichen Domänen, von der öffentlichen Verwaltung über industrielle Branchen und Mobilitätsdienste bis zur Medizin, Anwendung. In der Gaia-X-4-Future- Mobility-Projektfamilie werden beispielsweise Datenversorgungen automatisierter Fahrzeuge, Systemverbünde von Fahrzeugen, Produktlebenszyklen und Digitale Zwillinge für das automatisierte Fahren betrachtet.

Catena-X greift die Grundprinzipien von Gaia-X auf und befähigt Unternehmen mittels »Policies« den Zugriff auf ihre Daten nur spezifischen Unternehmen oder Unternehmen, die das Innehaben einer bestimmten Rolle durch ein Zertifikat nachweisen können, zu gewähren. Unternehmen, die keinen Zugriff erhalten haben, erfahren dabei nicht einmal unbedingt, dass die Daten existieren. Neben dem Zugriff können über die Policies die Bedingungen für die Nutzung definiert werden, beispielweise, dass Daten nur in bestimmten Regionen oder für bestimmte Zeitintervalle genutzt werden dürfen. Damit kann beispielsweise gewährleistet werden, dass zugelassene bzw. zertifizierte Verwertungsbetriebe Daten über die in einem Fahrzeug verwendeten Materialien und deren Lieferkette für Verwertungszwecke falls erforderlich einsehen dürfen, Konkurrenzunternehmen die Materialzusammensetzung jedoch nicht einsehen können.

Datendurchgängigkeit: Nahtlos Daten fließen lassen

Datendurchgängigkeit bezieht sich auf die nahtlose und konsistente Nutzbarkeit von Daten über verschiedene Datenquellen und Anwendungen. Die Quellen sind IT-Systeme, Plattformen oder Datenbanken und finden sich entlang des gesamten Produktlebenszyklus. Dazu gehören beispielsweise PLM-Systeme der Produktentwicklung, ERP-Systeme der Produktion und IoT-Plattformen aus der Nutzungsphase. Zu den Schlüsselaspekten der Datendurchgängigkeit zählen folgende Aspekte:

- Integration vielfältiger Datenquellen, z. B. Daten von Legacy-Systemen in aktuelle IT-Umgebungen

- Mapping verschiedener Daten, z. B. Mapping von Energiedaten der Fertigung in LCA-Modelle der Produktentwicklung

- Zugriff auf Realdaten oder Echtzeitdaten, z. B. Überwachung und Steuerung von 3D-Druckprozessen

- Einheitliche Datenformate und Standards, z. B. Schaffen von Interoperabilität zwischen Entwicklungs und Produktionssystemen

- Datenqualität und Governance, z. B. Etablieren von Governance für den unternehmerischen Umgang mit produktbezogenen Daten

- Managen von Änderungen, z. B. Definieren von technischen und zeitlichen Gültigkeiten von Daten

Eine nahtlose Datendurchgängigkeit wird durch einen nahtlosen Datenfluss in Unternehmen und auch unternehmensübergreifend geschaffen. Der Datenfluss wird dabei durch die vereinheitlichten Datenformate und -modelle erreicht, wie auch durch die notwendigen Schnittstellen zwischen den IT-Systemen. In den vom Fraunhofer IPK durchgeführten Datenflussanalysen wurde deutlich, dass die Datendurchgängigkeit oftmals als isolierte Herausforderung der Informationstechnik verstanden wird. Tatsächlich sollte sie sich jedoch an der digitalisierten Wertschöpfung orientieren. Hier werden neben den Formaten und IT-Systemen auch die wertschöpfenden Aktivitäten, koordinierenden Prozesse der Ablaufstruktur und die strukturierenden Organisationen der Aufbaustruktur adressiert. In dieser Betrachtung wird immer wieder deutlich, dass die Datendurchgängigkeit als Rückgrat der Wertschöpfung zu verstehen ist.

Datenbasierte Geschäftsmodelle: Wert aus Daten schöpfen

Anhand der von Sensoren und vernetzten Maschinen erhobenen Echtzeitdaten können Werksleitung und Fachpersonal Produktionsabläufe und Maschinenzustände genau überwachen. So können sie Engpässe oder Störungen frühzeitig erkennen und beheben. Darüber hinaus eröffnen Datenanalysen Möglichkeiten für präventive Instandhaltung. Durch die Auswertung von Sensordaten lassen sich Wartungsbedarfe prognostizieren. Dadurch werden ungeplante Ausfallzeiten reduziert und die Lebensdauer von Anlagen verlängert – mit einer verbesserten Effizienz der gesamten Produktionsanlage bei gleichzeitig sinkenden Betriebskosten als Folge.

Dem Unternehmensmanagement können gewonnene Daten zudem als Grundlage für neue Geschäftsmodelle dienen. Produzierende Unternehmen können Datenlösungen als eigenständiges Produkt anbieten oder mit Partnerunternehmen kooperieren, um neue Leistungsangebote am Markt zu platzieren. Sie können beispielsweise ihr Know-how in der Datenanalyse monetarisieren und damit neue Einnahmequellen erschließen. Auch in der Personalisierung von Produkten und Services liegen Potenziale für datenbasierte Geschäftsmodelle. Durch die Auswertung von Kunden- und Nutzungsdaten können Unternehmen individuelle Lösungen anbieten, die auf die Bedürfnisse und Vorlieben ihrer Kundinnen und Kunden zugeschnitten sind. Dadurch steigt nicht nur die Kundenzufriedenheit, sondern es eröffnen sich auch neue Umsatzmöglichkeiten durch maßgeschneiderte Produkte und Serviceleistungen.

Fraunhofer-Institut für Produktionsanlagen und Konstruktionstechnik

Fraunhofer-Institut für Produktionsanlagen und Konstruktionstechnik